こんにちは、富士通研究所データ&セキュリティ研究所の吉井章人と園田亮介です。この記事ではデジタルフェイク対策技術の一つとして、私たちが開発しているディープフェイク検知技術について紹介します。

こんにちは、富士通研究所データ&セキュリティ研究所の吉井章人と園田亮介です。この記事ではデジタルフェイク対策技術の一つとして、私たちが開発しているディープフェイク検知技術について紹介します。

生成AIなどの普及により、実在しないデジタルフェイクが誰でも容易に作れるようになりつつあります。 最近ではリアルタイムでも高い品質で、現実と見分けるのが難しい画像や動画が生成できることから、 著名人や政治家などになりすまして架空の発言を広めたり、文書を巧妙に改ざんして取引で損害を与えたりすることが想定されます。 技術の進歩が速い現在、AIを悪用した事件や事故を防ぐためにデジタルフェイクを検知できる技術が求められているのです。

富士通研究所では、信頼できるAIとの共存を目指して、デジタルフェイクの対策技術を開発しています[1]。 この度、私たちは技術をアピールするデモをFujitsu Technology Update 2025[2]で発表しました。 まず最初にデモの概要を紹介したのちに、ディープフェイク検知技術について説明したいと思います。

デモの動画をご覧ください。最初にビデオ通話の様子が登場します。

ビデオ通話の人物はAIで顔を入れ替え、弊社社長[3]になりすましています。この人物の顔に対して赤枠を描画し、顔が改ざんされていることを表示しています。

さらに、枠の上には小さな画像が表示されています。これらは、顔画像の中で改ざんされていると判断を下すのに影響した領域が抜粋されてヒートマップで表示したものです。

また、顔以外にもレシート画像や請求書などの文書が改ざんされているかを分析し、判定結果だけでなくどの部分が事実と異なるかも表示しています。

ディープフェイク検知技術について

ディープフェイク動画の増加は、個人や社会の安全とプライバシーに大きな脅威をもたらしており、デジタル社会において、現実と偽物の区別を見分けられない時代へと導くことが懸念されています 。 既存のディープフェイク検出技術は、人種や性別などの人口属性によって、ディープフェイクだと判定されやすい/されにくいなどのバイアスが生じてしまう課題があります。 私たちは、公平性と解釈可能性(透明性)を高めるため、時系列特徴学習と人口属性を考慮するデータ水増しを統合した、公平性を意識した新しいディープフェイク検出技術を提案しています。

コンセプト抽出による解釈性

動画の人物のどの部分が改ざんされているのか、人間が理解可能な表現で表示されれば、ユーザは専門家でなくても結果を理解することができます。 改ざんが疑われる領域に加えて、髪型やアクセサリーなど、顔に関する特徴を言語化されたコンセプトとして定義しておき、コンセプトの抽出結果も表示することができます。また、顔の特徴に加えて、動画のフレーム間に生じる時系列の不一致などの特徴も考慮することができます。

公平なデータ拡張技術

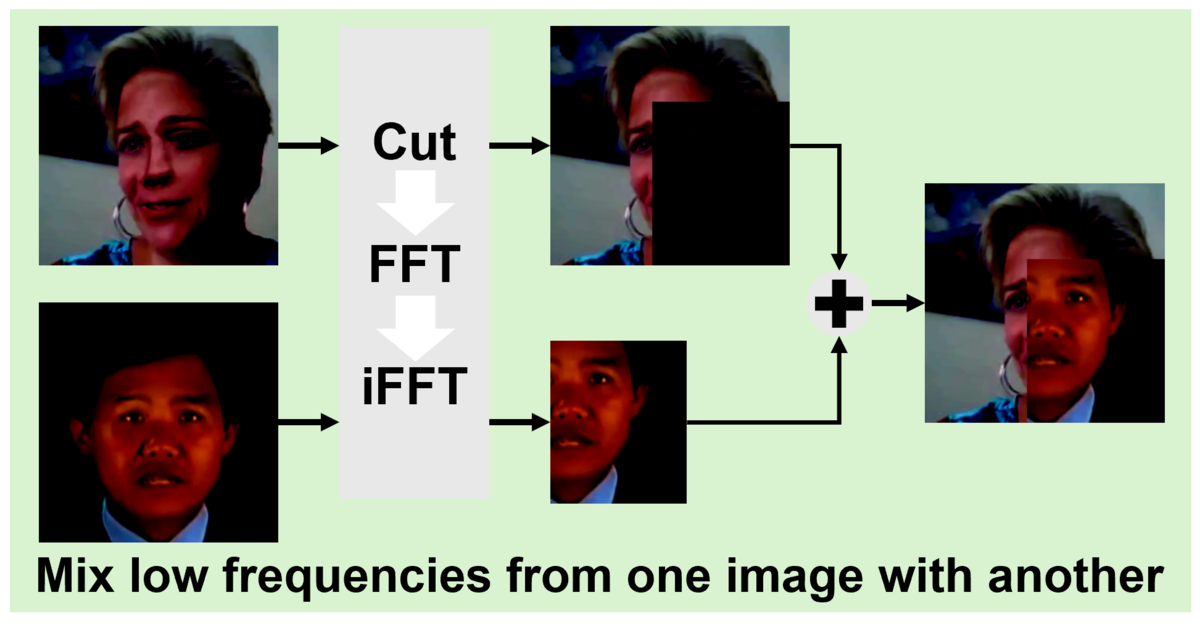

提案手法のデータ拡張技術は、訓練データに含まれる人口属性バイアスを軽減し、検出モデルの公平性を向上させることを目的としています。 従来のデータ拡張技術は、異なる画像を混合させることで訓練データの多様性を確保し、モデルの検出性能を改善することを目的としますが、データの人口属性のバランスを考慮せず、またディープフェイク特有の高周波成分にある偽造の痕跡を破壊してしまう欠点がありました 。 提案手法は、周波数領域に着目したデータ拡張を採用し、ディープフェイクの偽造痕跡が多く含まれる高周波成分は保持しつつ、バイアスが存在しやすい低周波成分を選択的に他の画像と混合します。 また、公平性をさらに改善させるため、異なる人口属性を持つデータ同士を優先的に混合させます。 上記によってバイアスを効果的に低減し、同時に、検出に不可欠な高周波の偽造痕跡を維持するため、公平性と検出精度の両立を実現しています。

まとめ

AIは多くの可能性を秘めている反面、悪用によってディープフェイクなどの偽情報が拡散することで社会問題を引き起こす可能性があります。 私たちはAIによる社会問題を防ぐためデジタルフェイク対策技術開発を進めています。 本記事では、公開したデジタルフェイク対策技術の概要と、その要素であるディープフェイク検知技術について説明しました。