はじめに

こんにちは。AIトラスト研究センター)成田です。

AIトラスト研究センターでは、研究所の先端AI技術を公開するためのプラットフォーム Fujitsu Kozuchiを通して、多くのお客様に我々の技術を素早く提供することで価値検証と技術の改善を迅速に進めていく取り組みを行っています。

この度、Fujitsu KozuchiのAIコアエンジンの一つとしてAIモデルの公平性の検証や改善が容易にできる『Fujitsu AI Ethics for Fairness』を一般公開しました。

https://portal.research.global.fujitsu.com/

※ログイン後、技術一覧からFujitsu AI Ethics for Fairnessを選択してください

この記事では、Fujitsu AI Ethics for Fairnessの内容と利用方法について紹介します。

AI倫理ってなぜ必要?

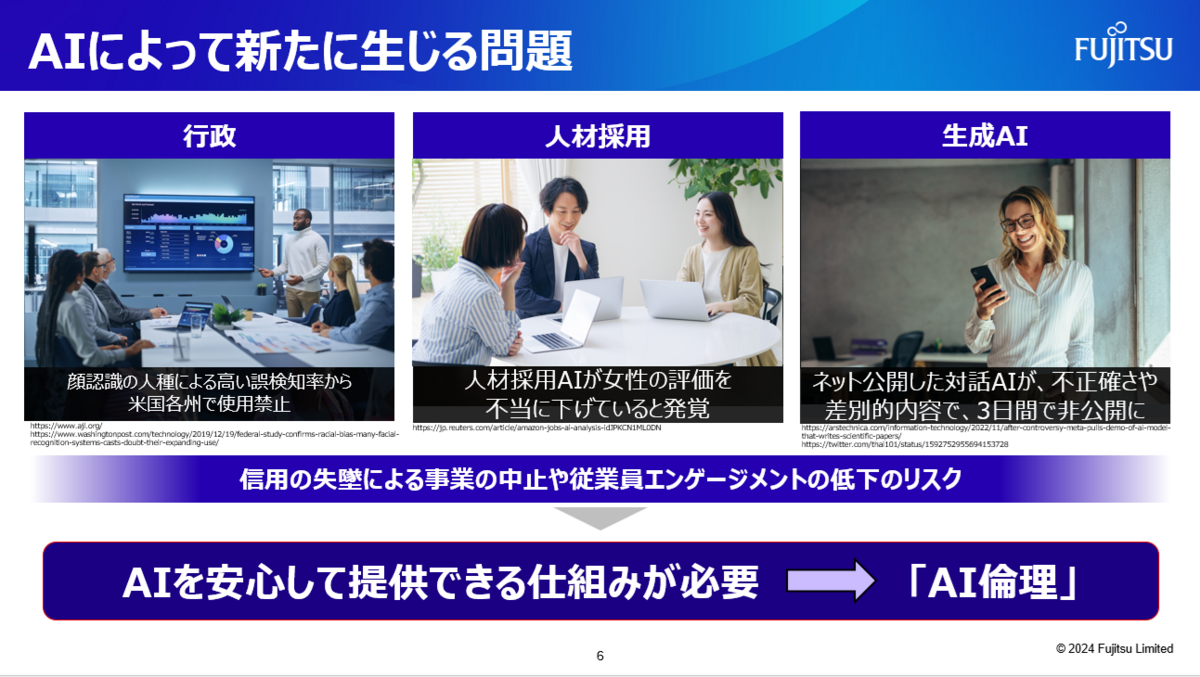

近年、AIは人材採用や顔認識など人間の判断支援を行うようなサービスにも利用されるようになり、AIが偏見や差別的な判定を行った場合のリスクが大きくなってきています。

例えば、ある企業が開発した人材採用AIが、男性を偏重するという欠点が判明し運用を取りやめたり(※1)、米国では複数の州で顔認識技術の使用を禁止しています(※2)。

AIは上手に扱えば非常に強力なツールですが、用途や扱いを誤ると、企業の信用を失墜させたり、ビジネスチャンスを失ったりする諸刃の刃でもあります。

※1. 焦点:アマゾンがAI採用打ち切り、「女性差別」の欠陥露呈で | ロイター

※2. 顔認識技術は“敵”か味方か? 規制と導入の狭間で揺れる米国 | WIRED.jp

AIという便利なツールをより安心して使ってもらうためには、このようなAIの倫理的に問題のある判定を防ぐ、あるいは改善する何かしらの仕組みが必要です。 これが我々の目指す『AI倫理』です。

AIの公平性ってどう測る?

AI倫理の中の1つの考え方に公平性という考え方があります。

これはつまり『AIの判定がセンシティブな属性(性別や人種など)について公平な判定をおこなう』ということを示すことで、そのAIは公平であり倫理的な側面においてリスクが低い、

と説明するアプローチです。

例えば、「ローン審査AIが性別について不公平な判定をした」とは、そのローン審査AIについて男性のローン審査通過率と女性のローン審査通過率に著しい差が発生した状態をさします。 逆に考えると、AIを公平な状態にするには、センシティブ属性によらず、同じ条件であればポジティブ率(例えばローン審査の通過率)を男女で同等にする操作を行うことになります。

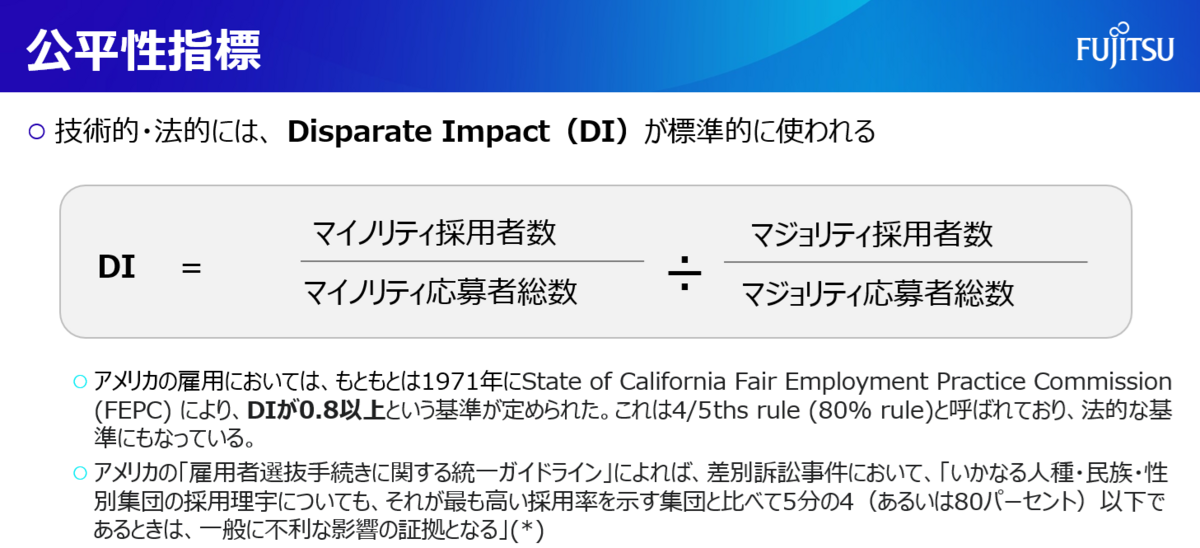

この公平性の度合いには様々な指標がありますが、ここでは一般的なDisparate Impact(DI)を紹介します。

あるAIの判定結果について、センシティブ属性のマイノリティ採用率をマジョリティ採用率で除算することで求まり、DIは1に近いほど公平である、と考えられます。

(*) 「アメリカにおける人事採用政策に対する法的規制」(1991) https://www.jstage.jst.go.jp/article/jaiop/5/1/5_19/_pdf/-char/ja

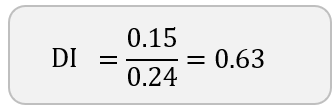

DI計算例.

具体的な数値で見ていきましょう。

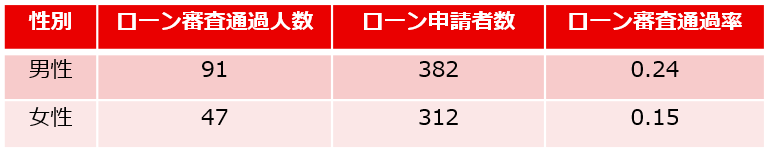

とあるローン審査業務において、性別、年収などの個人情報を元にローン審査通過を判定するAIが存在したとします。 ここでそのAIの入力には性別情報という、ローン審査通過の有無には関与すべきではないセンシティブな属性が含まれていたため、性別について公平であるかを調査することを考えます。

ここで、入力されたデータが下記のような割合だったとします。

※数値自体は架空のものです

このとき、マイノリティ採用率=女性のローン審査通過率=0.15となり、マジョリティ採用率は同様に0.24となります。 このため、DIは下図のとおり0.63となり、DIが0.8以下が不公平だとすると、このAIは女性に対して不公平な判定を行うAIと考えられます。

このように、そのAIの判定結果とセンシティブ属性によって、DIを測ることができます。

ただし、この数値は個々人の年収やローン返済能力や、借入金額などの条件などを考慮していない計算式のため、これだけでは必ずしも不公平とはいえない(厳密にはより詳細な調査が必要)点には注意してください。

あくまで目安の1つとなります。

Fujitsu AI Ethics for Fairnessとは?

いよいよFujitsu AI Ethics for Fairnessの紹介です。

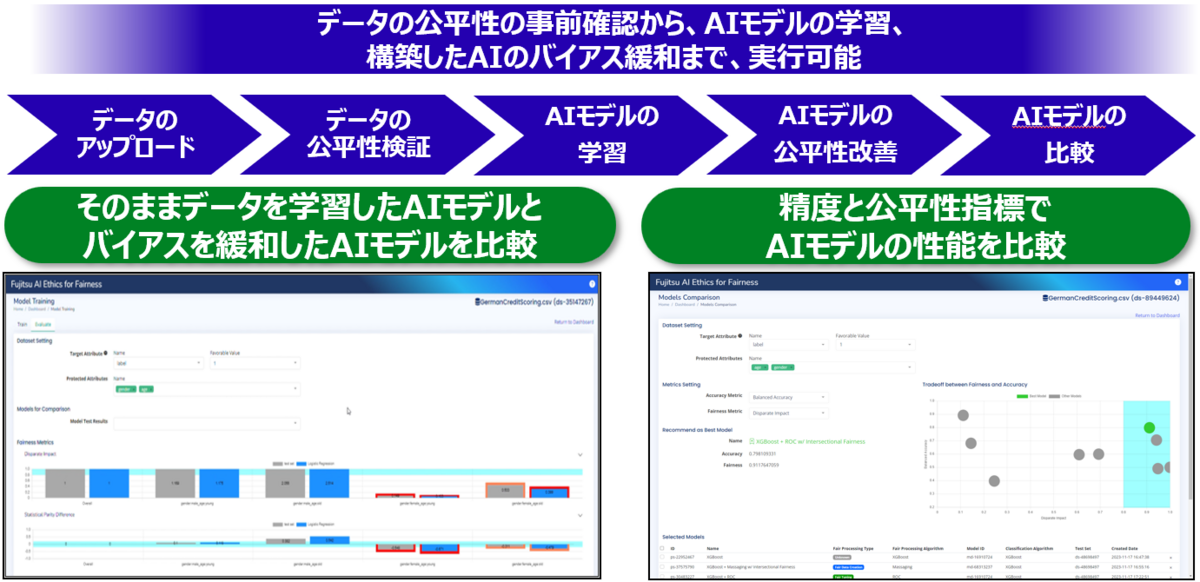

Fujitsu AI Ethics for Fairnessは、AIの公平性を容易に検証・改善できるWebアプリケーションです。 AIの学習データや判断の公平性を、Webブラウザから簡単な操作で検証したり、必要に応じて改善することが可能になります!

ここまで簡単にAIの公平性についてご紹介しましたが、AIの公平性の測り方や、その改善方法は様々なものが提案されています。 これらの専門技術をAI倫理の非専門家や、プログラム開発スキルが無い人でも活用し、AIの公平性の検証や改善が行えるようになります。

富士通独自技術の実証研究としての側面も

Fujitsu AI Ethics for Fairnessには、交差バイアスを緩和する富士通独自技術としてIntersectional Fairness (ISF)が同梱され、複数のセンシティブ属性で公平性を改善することも可能です。

交差バイアスとは、複数の属性の組み合わせにより差別が⽣じる現象のことで、人間が気付きづらい、大きなバイアスが発生していることがあります。 例えば未婚のシングル・マザーに対する差が、性別、婚姻状況、⼦供の有無のそれぞれで想定される差別よりも⼤きく現れる現象などです。

ISFはLinux Foundationと連携し、オープンソースソフトウェア(OSS)として公開されています。

pr.fujitsu.com

Fujitsu AI Ethics for Fairnessを使ってみよう

ここからは実際にFujitsu AI Ethics for Fairnessを使ってみることにしましょう。

Home - Fujitsu Research Portalから一般公開されたFujitsu AI Ethics for Fairnessをご利用いただけます。

portal.research.global.fujitsu.com

- ご利用にあたり、事前にポータルでアカウント登録いただく必要があります。

- アカウント登録の方法は以下をご参照ください。

https://blog.fltech.dev/entry/2023/09/29/annoucing-fujitsu-research-portal-ja

ポータルにログイン後、Fujitsu Research Portal > 技術一覧をクリックし、

Fujitsu AI Ethics for Fairnessから[お試しはこちら]を選択してください。

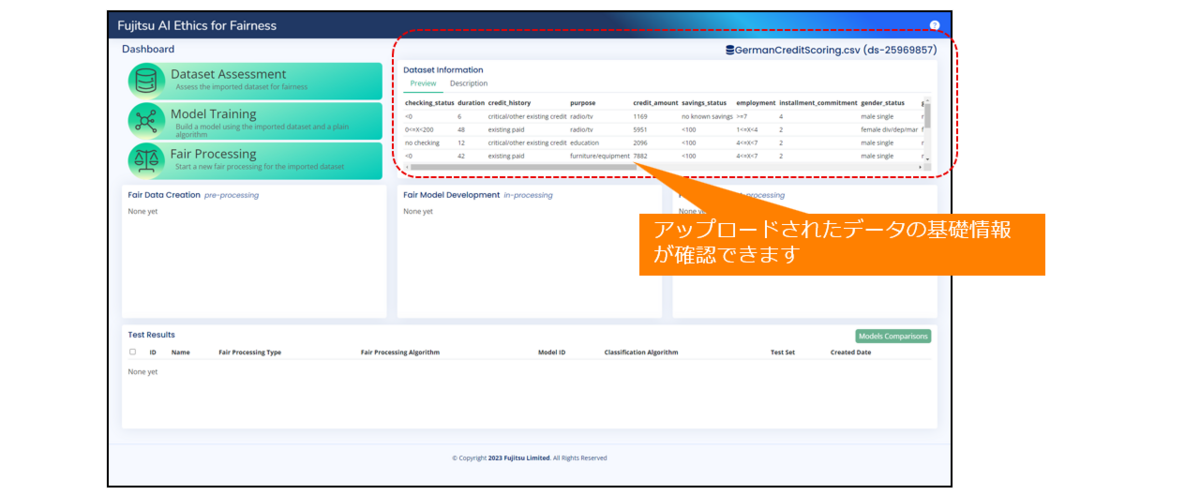

1. データのアップロード

公平性を検証したいデータ(csv)をアップロードします。

サンプルデータはHome - Fujitsu Research Portalで公開している他、お手持ちのcsvをアップロードすることもできます。

アップロードされたデータの行列数など基礎的な情報が表示されます。

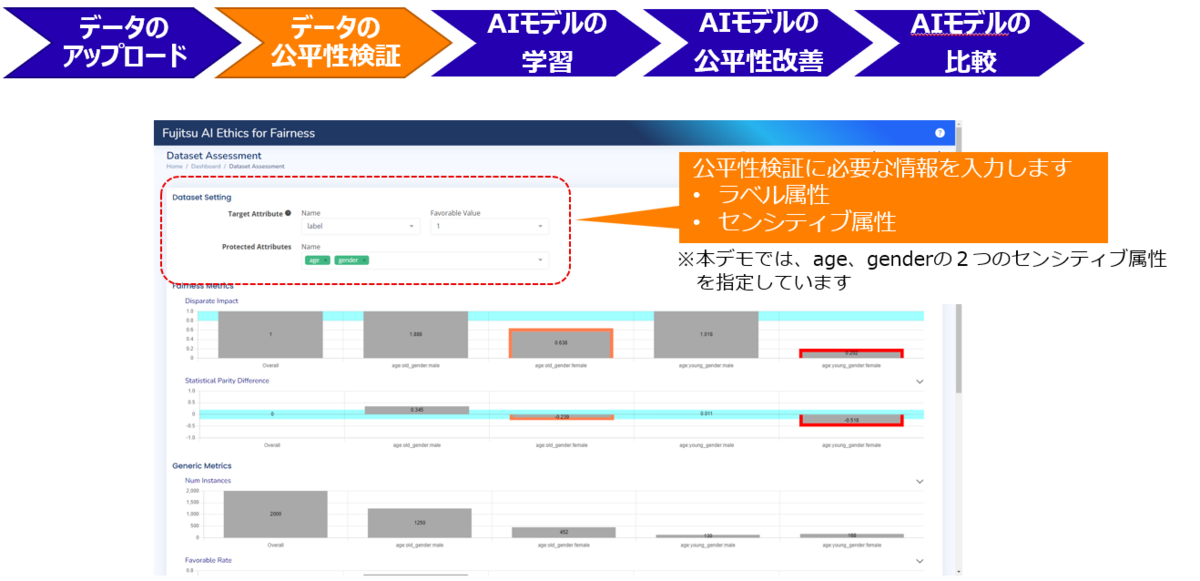

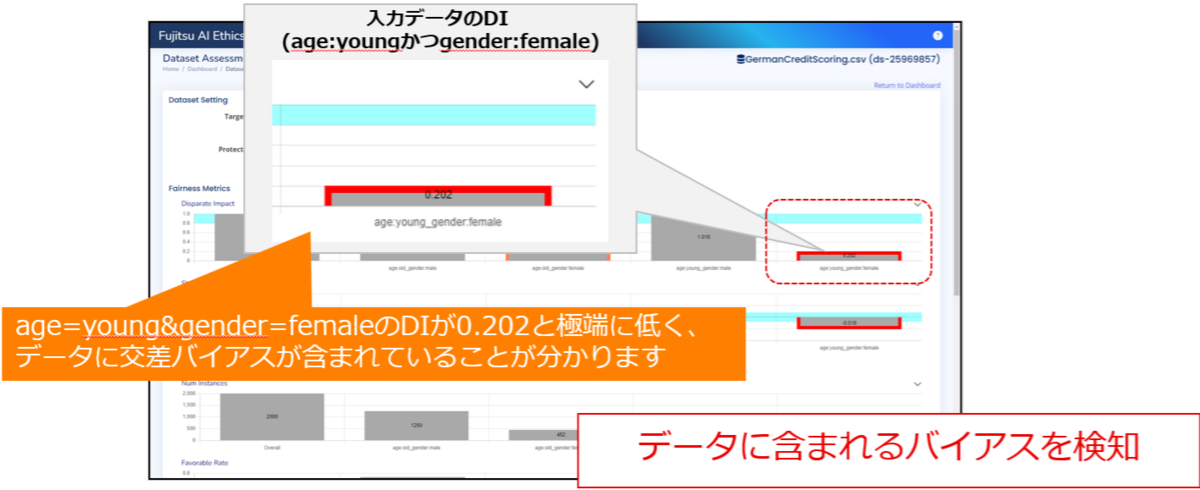

2. データの公平性検証

まず、アップロードされたデータの公平性を検証します。

csvに含まれるセンシティブ属性やラベル属性を指定することで、DIが計算されます。

- このスクリーンショットではセンシティブ属性にage、genderの2種を指定しているため、それぞれの属性値の組み合わせでDIを表示しています。

age属性の値がyoung、gender属性の値がfemaleのDIが著しく低いです。

つまりこれは、このデータが若い女性に対して不公平なデータの可能性があることを示しています。

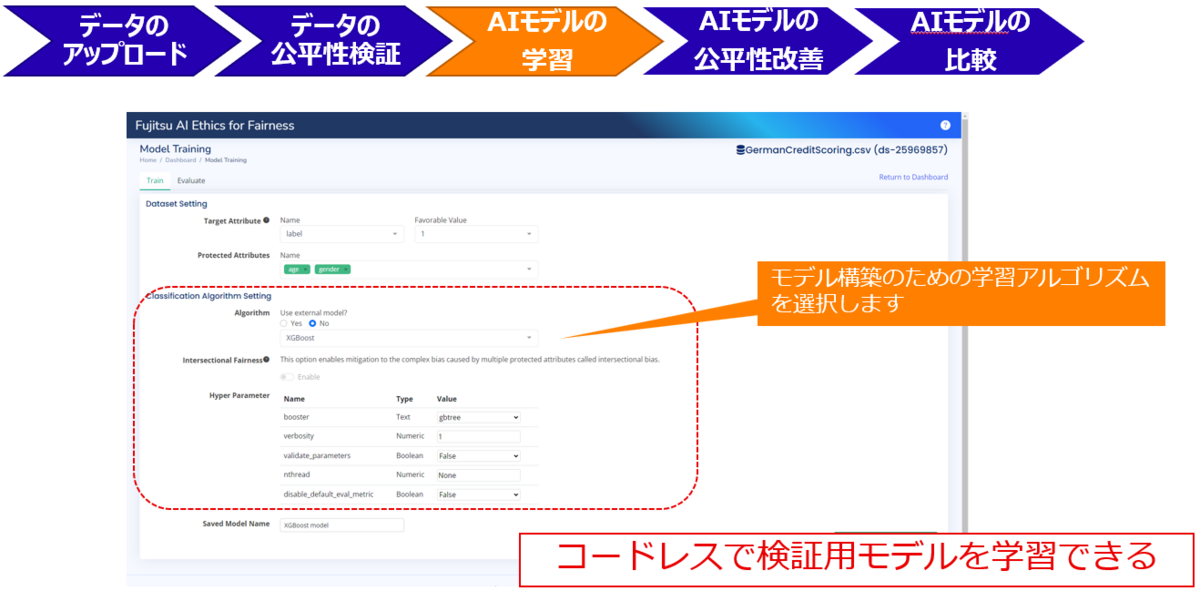

3. AIモデルの学習

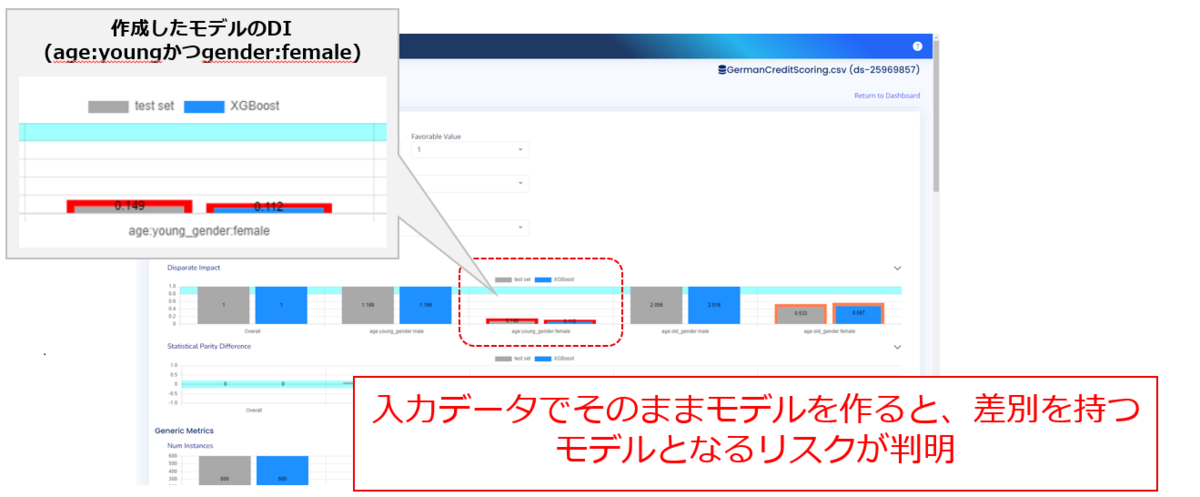

このデータを元にAIモデルを作成したとき、そのAIモデルも不公平な判断を行うかも検証します。

- ここでは学習アルゴリズムにXGBoostを選択しモデルを作成しますが、他のアルゴリズムも選択できます。

検証用に作成したAIモデルでもDIが低いことが分かりました。

検証用に作成したAIモデルでもDIが低いことが分かりました。

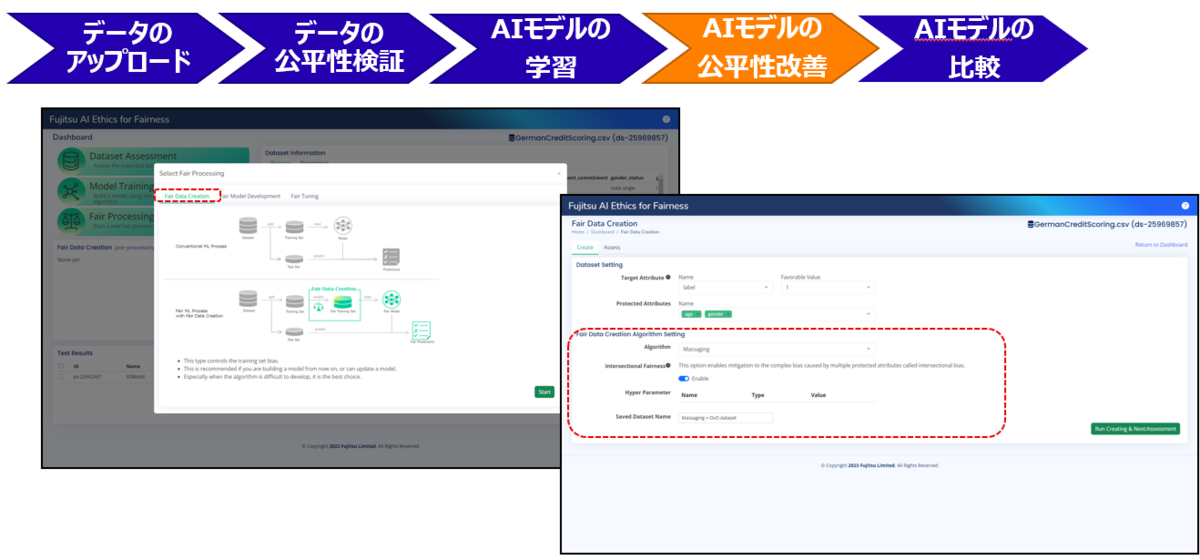

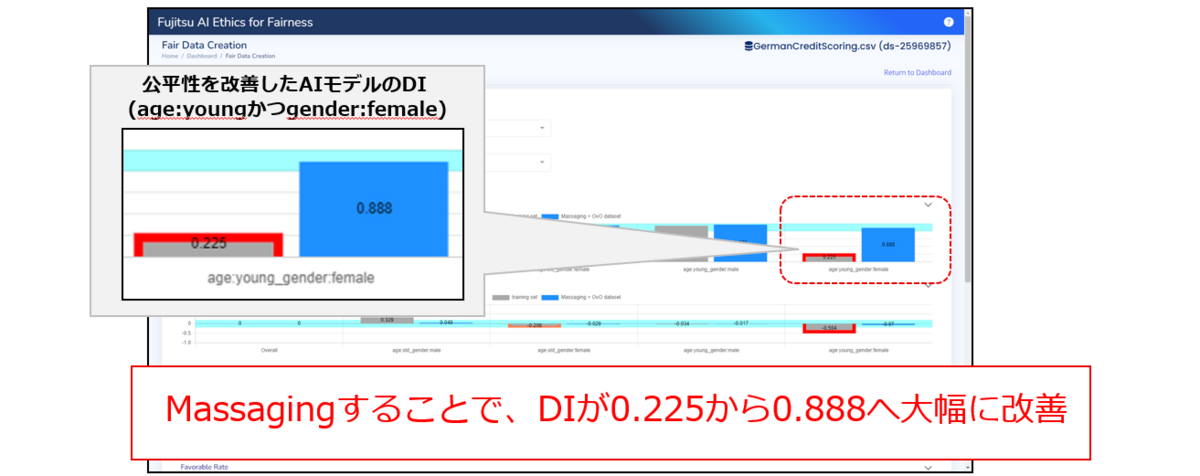

4. AIモデルの公平性改善

ここまでで、入力したデータに不公平な情報が含まれており、これを緩和しないとAIモデルも同様に

不公平な挙動をすることが確認できました。

そこでこのステップからは、アップロードしたデータの公平性改善(バイアス緩和)を行います。

公平性の改善手法はいくつかありますが、今回はアップロードしたデータに不公平な情報が含まれていたため、データのバイアスを緩和する『Massaging』という手法を選択し改善効果を検証します。 Fujitsu AI Ethics for Fairnessでバイアス緩和技術を利用する場合、複雑なプログラミングなどは不要です。

Massagingを用いて公平性を改善した結果、DIが大幅に改善することが確認できました。

5. AIモデルの比較

公平性の改善手法アルゴリズムやモデルの学習アルゴリズムは様々なものがあり、案件ごとに最適なアルゴリズムやハイパーパラメータは変化します。また、センシティブ属性も様々なものに変えて多角的に調査する必要があります。

そのため、2.データの公平性検証から4. AIモデルの公平性改善は設定を変えて複数回試行する場合が多いです。

そこで最後のステップとして、試行錯誤してできたAIモデルを比較し、最適な公平性改善モデルを決定します。

この例では最終的に、XGBoostで学習したモデルと、RoCというバイアス緩和アルゴリズムの組み合わせが、最も良いAccuracy(分類精度)とFairness(DI)を得ることができました。

このように、Fujitsu AI Ethics for Fairnessを用いれば複雑なプログラムや操作をせずに、公平なAIを構築するための知見を得ることができます。

おわりに

Fujitsu AI Ethics for Fairnessでは、AIの開発・利用に今後重要となってくるAI倫理(特に公平性)の技術を、AI倫理の非専門家や、プログラム開発スキルが無い人でも、容易に利用することができます。

ぜひみなさんにもFujitsu AI Ethics for Fairnessに触っていただき、ご興味・関心のある方は下記までご連絡ください。

問合せ先:k.narita at fujitsu.com (atは@) AIトラスト研究センター)成田